|

|

RECURSOS TECNOLÓGICOS PARA LA INTERVENCIÓN EN TRASTORNOS DE LA AUDICIÓN RECURSOS TECNOLÓGICOS PARA LA INTERVENCIÓN EN TRASTORNOS DE LA AUDICIÓN

Trastornos de la audición

La mayor o menor importancia de las pérdidas auditivas viene determinada por:

- el momento en que esta se produce: prelocutivas (antes del desarrollo del lenguaje) o postlocutivas (posteriores a su desarrollo) y,

- el grado de pérdida de audición.

Así tenemos:

- Hipoacusias. Caracterizadas por una disminución en la agudeza auditiva. Las pérdidas auditivas pueden ser consideradas como leves (20 a 40 db) o medias (40 a 70 db).

- Anacusia o sordera. Pérdida severa (superior a 70 db) o total de la agudeza auditiva .

Los recursos tecnológicos nos permiten obtener información sobre el proceso en portales y páginas especializadas. También disponemos de videos y animaciones que ofrecen una imagen clara sobre el proceso de audición y los tipos de pérdida auditiva

acceder

En los procesos de intervención con niños que presentan pérdidas de audición es importante la estimulación auditiva precoz que potencie el desarrollo de su capacidad auditiva.

En la intervención logopédica de los sujetos con pérdidas auditivas existen diferentes estrategias encaminadas principalmente a:

- La potenciación de los restos auditivos para la adquisición y desarrollo del lenguaje oral utilizando las tecnologías y prótesis de ayuda.

- El uso de la lengua de signos manual como acompañante al desarrollo del lenguaje oral o medio de comunicación en personas con graves pérdidas de audición.

Prótesis y ayudas técnicas

En los casos en que existe una lesión del oído interno, o una lesión neuronal o cerebral que impide la percepción de los sonidos, es necesario utilizar una prótesis que aumente la audición del sujeto. Las ayudas aumentativas de comunicación pueden ser:

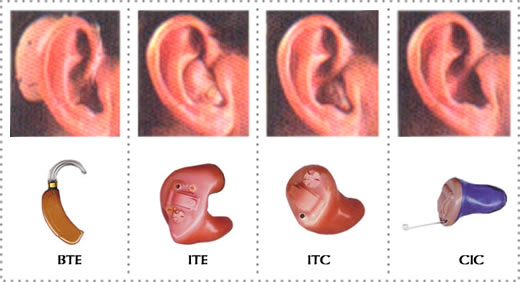

- Los audífonos, son prótesis de ayuda que permiten a las personas con pérdidas de audición, transferir los umbrales de percepción auditiva "normal" a los umbrales de percepción del hipoacúsico, para ello realizan una amplificación de los sonidos. Básicamente, el sonido es captado por un micrófono que convierte las ondas sonoras en señales eléctricas, estas pasan a un amplificador, donde la señal puede transformarse y amplificarse adaptándose a las necesidades de cada persona, y de aquí al auricular, que vuelve a convertir las señales eléctricas en sonido.

- El implante coclear es un aparato o dispositivo electrónico que ayuda a la persona sorda a escuchar. El implante no es un amplificador sino un codificador cuya misión es realizar el trabajo de la coclea, por lo que la la información dada por el implante es representativa del sonido original aunque limitada. Los pacientes candidatos a recibir un implante coclear, deberán reunir las siguientes condiciones.

- Niños de más de 18 meses, aunque esta edad es un tanto relativa, porque se han implantado niños, incluso de 6 meses.

- Hipoacusia neurosensorial bilateral, con umbral auditivo superior a los 90 decibelios

- Ausencia de beneficios con prótesis auditivas

- Alta motivación para integrarse en un programa de Implantes Cocleares

- Conocimiento de las expectativas de los resultados que se pueden obtener de un Implante Coclear

- Ausencia de contraindicaciones desde el punto de vista médico del paciente.

- Por último, y es el punto más importante, plena dedicación en un programa de rehabilitación, o mejor dicho de habilitación para el desarrollo del lenguaje.

- El implante tiene cuatro partes:

- La pieza externa o auricular integrado se sitúa detrás del oído, encima de las partes que se encuentran debajo de la piel, manteniéndolas unidas mediante imanes o magnetos. Esta compuesta por un micrófono que recoge los sonidos del ambiente o los alrededores y un transmisor que envía los sonidos al procesador del habla.

- Un procesador del habla, que selecciona y organiza los sonidos recogidos por el micrófono y los transforma en señales electrónicas que son enviadas al receptor interno.

- El receptor/estimulador interno, se encuentra colocado debajo de la piel en la parte de atrás del oído, capta las señales del procesador del habla y las conduce al oído interno a través de un conjunto de electrodos.

- Electrodos, que se sitúan en la cóclea, reciben las señales enviadas por el receptor y las pasan al cerebro para que sean interpretadas.

¿Cómo funciona el implante coclear?

- Los implantados cocleares requieren una laboriosa rehabilitación para poder interpretar estos estímulos eléctricos como señal acústica, siendo este proceso largo y requiere la intervención logopédica especializada.

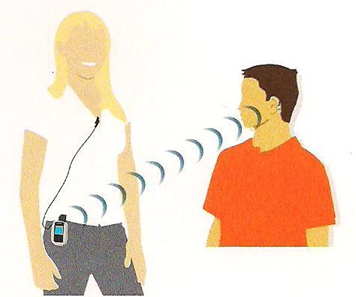

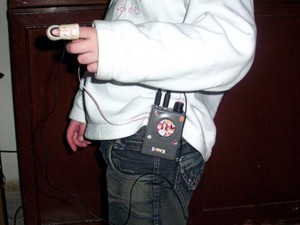

- Los sistemas de FM. Son una ayuda técnica para salvar los problemas derivados de las condiciones acústicas adversas, tales como sonido de fondo y reverberación, o de la distancia entre emisor y receptor. Los sistemas de FM pueden ser utiles con personas que utilicen audífonos o implantes cocleares, pues actuan conjuntamente con ellos mejorando la calidad de la percepción del sonido. También pueden ser útiles en personas con perdidas auditivas leves.

En general, los sistemas de FM consisten en un sistema de comunicación simple: un transmisor, un micrófono y un receptor. Los sistemas de FM personales proporcionan una comunicación directa entre la persona que habla y el usuario y ayudan a concentrase en las voces o sonidos que necesitan ser escuchados. El micrófono acoplado al transmisor recoge la señal y la envía en forma inalámbrica al receptor. En el receptor la señal es convertida nuevamente en una señal de audio y puede llegar al usuario a través de un auricular, el audífono o el procesador del implante.

- Los sistemas vibrotáctiles. Los estimuladores táctiles o vibradores son aparatos que se suelen colocar en las zonas corporales que reciben mayor información sobre el carácter de la vibración. Amplifican las vibraciones sonoras y las convierten en vibraciones mecánicas que se perciben de forma táctil en zonas sensibles, especialmente las muñecas y las palmas de las manos. Estos dispositivos permiten a las personas con trastornos de audición percibir el sonido a partir de las vibraciones percibidas mediante el tacto. Las vibraciones percibidas permiten, mediante un entrenamiento adecuado, identificar sonidos. Generalmente los sistemas vibrotáctiles son complementarios a los sistemas de estimulación auditiva.

- El Sistema Universal Verbotonal de Audición Guberina (SUVAG) son amplificadores de sonido, que se utilizan en la educación verbotonal (MVT) para trabajar sobre bandas de frecuencias, que no utilizan los oyentes, pero que pueden ser óptimas para los deficientes auditivos. Guberina y su equipo han comprobado que las frecuencias bajas son las que mejor transmiten los elementos suprasegmentales del habla. Por lo tanto es fundamental el aprovechamiento de estos restos auditivos y su utilización en la rehabilitación y en la estimulación precoz. En el caso de los deficientes auditivos el MVT. delimita para cada persona deficiente auditiva una zona frecuencial óptima que le ayudar;a a percibir y emitir mejor su habla. A esta zona la denominamos "Campo Optimo de la Audición". Este campo no es el mismo a lo largo de la rehabilitación, pues va cambiando y ampliandose.

Lenguaje oralista

En este apartado revisaremos los recursos tecnológicos que podemos utilizar para a partir de sus restos auditivos, potenciar la comunicación oral de la persona con trastornos de audición y/o implante coclear.

Existen diferentes metodologías en la evaluación y rehabilitación de las personas con trastornos de audición, en las cuales tendremos que tener presente tanto el grado de pérdida de audición como el momento en que se produce la pérdida (prelocutiva o postlocutiva). Las actividades y ejercicios a realizar partiran de los ruidos y sonidos del entorno, para acceder paulatinamente a la palabra y los diálogos. Las actividades que pueden realizarse en este ámbito son:

- Detección. Distinguir el momento en que se produce un sonido. Ejercicios de ausencia/presencia de sonido.

- Discriminación. Distinguir si dos sonidos son iguales o diferentes.

- Identificación. Identificar los ruidos, sonidos, las sílabas y palabras.

- Asociación. Asociar los sonidos con una imágen o representación gráfica de los mismos.

- Reconocimiento. Reconocer, memorizar y ordenar sonidos presentados secuencialmente.

- Expresión. Imitar o emitir los sonidos escuchados en presencia de su imagen.

- Comprensión. Comprensión oral a través de diferentes situaciones comunicativas: diálogos, noticias,...

- Integración. Completar palabras, frases y expresiones orales, atendiendo tanto al mensaje percibido oralmente, como a la comprensión de la información contextual (lectura labial, gestos, etc.).

La AICE (Asociación de Implantados Cocleares de España) basándose en la metodología verbotonal en la que se destaca la importancia de la audición para la adquisición del lenguaje, plantea los procesos de intervención estructurados en cuatro fases:

- Detección. Fase de condicionamiento al sonido, en la que se realizan ejercicios de ausencia/presencia de sonidos.

- Discriminación. Distinguir si dos sonidos son iguales o diferentes.

- Identificación. Identificar y reproducir sonidos mostrados.

- Reconocimiento. Reconocer y repetir un sonido, ritmo, palabra o frase

- Comprensión. Comprensión oral a través de diferentes situaciones comunicativas: diálogos, noticias,...

Antes de comenzar el proceso de rehabilitación logopédica es necesario tener presentes dos aspectos fundamentales.

- el momento en que esta se produce: prelocutivas (antes del desarrollo del lenguaje) o postlocutivas (posteriores a su desarrollo) y,

- el grado de pérdida de audición.

Por otro lado, en relación a las condiciones ambientales el lugar o sala en el que de va a realizar la rehabilitación debe estar acondicionado para ello estando aislado de los ruidos del entorno.

El software que podemos utilizar en los procesos de intervención dirigidos a lograr la discriminación auditiva y la adquisición del lenguaje oral, se puede clasificar en dos categorías:

- Visualizadores del habla. El sujeto emite sonidos y el programa produce un feedback visual o táctil. Entre los visualizadores se encuentran el Speech Viewer y Globus -ver apartado de fonología en habla/voz-, con los que podemos realizar ejercicios de:

- Ausencia y presencia de sonido

- Cualidades del sonido (sonoridad, intensidad, tono, duración y ritmo)

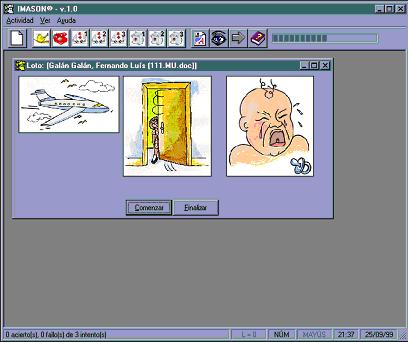

- Aplicaciones multimedia interactivas. El programa produce los sonidos junto con un estímulo visual relacionado y el sujeto responde a través del teclado u otro dispositivo de entrada de la información. Algunos programas que pueden resultar de interés para realizar actividades orientadas a la discriminación y comprensión auditiva, así como a la comprensión y expresión verbal son:

- Imason. Programa informático con el que podemos trabajar la percepción, discriminación y memoria auditiva. Para ello cuenta con un banco de datos, que permite que el logopeda adapte las actividades al usuario concreto, seleccionando los estímulos auditivos y visuales que interesen o incluyendo nuevas imágenes y sonidos.

-

- Juega con Simón de Edicinco. Simón ayuda al niño a memorizar, aprender y discriminar una gran cantidad de sonidos agrupados en diversas familias: ruidos de la calle, ruidos de casa, ruidos y sonidos del cuerpo humano, ruidos de la naturaleza, instrumentos musicales... todos ellos representados mediante gráficos y animaciones

-

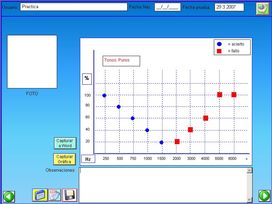

- Audiomatic creado por José Manuel Mancebo Ibáñez y José Antonio Ferrández Mora -distribuido por la empresa AEI Valencia-. Programa para el entrenamiento auditivo. Actividades de estimulación auditiva para la realización de entrenamientos en audiometrías tonales. Como complemento, incluye juegos interactivos a los que se puede acceder en línea, creados por la Fundación Arauz de Argentina.

-

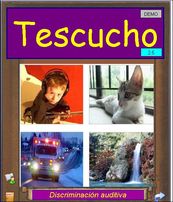

- Te Escucho de José Manuel Mancebo Ibáñez y José Antonio Ferrández Mora y distribuido por la empresa AEI Valencia. Programa abierto con posibilidad de crear actividades personalizadas y dirigido a la evaluación y entrenamiento de la discriminación auditiva. Incorpora, además de los sonidos, videos y fotografías.

-

- Discraudi y Discraudi II de Andreu Sauca y distribuidos por MIRELO. Discraudi es un programa semi-abierto, destinado a ser utilizado en el ámbito de la consulta logopédica, para el entrenamiento de la discriminación auditiva. Mientras que, Discraudi II, viene a ser una continuación del anterior, permitiendo trabajar la memoria auditiva y la discriminación de la figura y fondo sonoros, y de las características acústicas de volumen, tono y timbre. También facilita el trabajo de otras capacidades como la memoria auditiva inmediata y la secuencia sonora temporal.

-

- SEDEA distribuido por Onda Educa y realizado en colaboración con el equipo de rehabilitación del Colegio La Purísima para niños sordos de Zaragoza. Es un programa secuenciado de intervención para personas con deficiencia auditiva e implantados cocleares. Se basa en el Método Verbotonal estableciendo cinco fases en el proceso de intervención: detección, discriminación, identificación, reconocimiento y comprensión.

Lectura labial o labiofacial

En la adquisición del lenguaje oral por el deficiente auditivo asume gran importancia la lectura labial o labiofacial. La percepción del lenguaje se produce integrando las informaciones recibidas tanto desde la percepción auditiva como desde la percepción visual de la emisión del sonido. Por tanto, la lectura labiofacial complementa la información auditiva, por un lado ofrece información sobre el punto de articulación y, por otro lado, aporta información sobre la carga emocional de la expresión verbal.

La lectura labiofacial presenta una serie de limitaciones:

- No tiene el grado de precisión que presenta la percepción sonora.

- Es dificil distinguir los visemas de dos fonemas semejantes o con el mismo punto de articulación.

- Los visemas no distinguen entre las diferentes representaciones gráficas (letras) que puede tener un mismo fonema.

Video leer los labios por Sergio López Lozano:

Existen pocos programas que apoyen y ofrezcan ejercicios para el entrenamiento de la lectura labiofacial. Es importante tener en cuenta que

es recomendable que estos programas utilicen imágenes reales, preferentemente animaciones de visemas realizadas por una persona, por que favorece la imitación de forma inmediata y permite memorizar durante más tiempo la articulación del fonema. Entre los programas existentes para el aprendizaje y entrenamiento de la lectura labial tenemos:

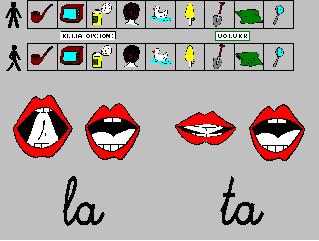

- Di. Es uno de los primeros programas cuyo objetivo era facilitar el aprendizaje de la lectura labial. El programa ofrece la posibilidad de visualizar los puntos de articulación de cada fonema aislado o formando parte de una palabra, al mismo tiempo que aparece escrito dicho fonema o dicha palabra.

- Sedea. Los ejercicios del programa Sedea permiten utilizar como apoyo la lectura labial.

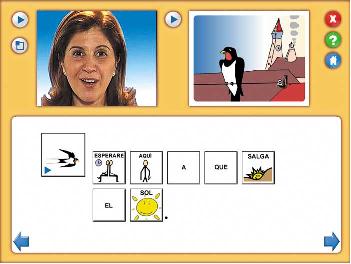

- Animacuentos de Onda Educa. Este recurso se dirige a fomentar la motivación por la lectura y el desarrollo lingüístico en los niños sordos y con problemas de comprensión y expresión a nivel tanto a nivel oral como escrito. Los cuatro cuentos que componen la colección se acompañan de un conjunto de actividades. Tanto en los cuentos como en las actividades que les acompañan podemos seleccionar como apoyo: el texto, la lectura labiofacial, el lenguaje de signos y/o el lenguaje bimodal.

Lenguaje signado

El lenguaje signado o lengua de señas es una lengua natural declarada lengua oficial de los sordos en 1988 por el Parlamento Europeo.

La Lengua de Signos (L.S.) es una lengua visual y gestual en la que se utiliza la expresividad de las manos, la cara y el cuerpo.

Es la lengua que utilizan algunas personas sordas, que les permite expresar sus pensamientos, sentimientos, ideas...considerándose como la principal vía de comunicación para poder relacionarse con los demás.

Posee su propia estructura.

Esta formada por elementos gramaticales que podemos comparar con los fonemas.

De la misma forma que los fonemas de la lengua oral se diferencian por diferentes puntos de articulación, los signos de la L.S. se distinguen por las distintas configuraciones de las manos y los dedos, es decir, sus parámetros.

Cada L.S. ha evolucionado de diferente forma en cada país y en cada comunidad, dando lugar a lenguas de signos distintas. Así incluso dentro de un mismo país existen diferencias geográficas en el uso de la L.S. En España el Congreso de Diputados reconoció en 2007 las lenguas de signos españolas, entre las que se encuentran la lengua de signos española (LSE) y la lengua de señas catalana (LSC).

El uso de la tecnología en relación al lenguaje de signos se ha producido en dos direcciones:

- Aplicaciones y recursos para el aprendizaje

- A signar. Aplicación multimedia para el aprendizaje de la lengua de signos. Está dividido en 6 bloques: familia, escuela, ocio, salud, personas, viajes y vacaciones. Es el primer método interactivo orientado al aprendizaje de la estructura morfosintáctica de la lengua de signos.

- Diccionario Sematos. El Portal Europeo de Lengua de Signos, incluye un video diccionarios de las lenguas de signos europeas. Contiene más de 6000 palabras organizadas con diferentes criterios: alfabético, por temas, por tipo.

-

- Dilse III Tesoro de la lengua de signos española. El diccionario de Tesoro de la LSE es el primer diccionario normativo de la Lengua de Signos Española, es un diccionario descriptivo y bilingüe (LSE-castellano) que también puede ser consultado a través de teléfono móvil.

- Recursos y servicios para la comunicación:

- Signe 2. Editor de textos, creado por Benjamí Vidiella, que permite crear textos en lenguaje escrito y traducirlos al lenguaje de signos con dibujos y videos. El programa puede ser utilizado como una herramienta que facilite la lectura de textos a las personas sordas y como recurso a utilizar por profesores y logopedas para la preparación de materiales dirigidos a las personas sordas que utilicen el lenguaje signado.

-

- SVisual La Confederación Estatal de Personas Sordas (CNSE) ha desarrollado el servicio de videointerpretación de Lengua de Signos Española que permite a personas sordas o con discapacidad auditiva y personas oyentes, comunicarse entre sí mediante la figura del video-intérprete de lengua de signos. De esta manera, sus usuarios pueden intercambiar información con total independencia y autonomía, desde su propia casa, y en la modalidad de comunicación que deseen, sin que sea necesario que el intérprete esté físicamente presente.

- Proyecto GANAS. El proyecto GANAS (Generador de Animaciones para el Lenguaje de Signos) tiene como objetivo proporcionar un 'traductor' de lengua escrita a lengua de signos para las personas con discapacidad auditiva. La solución está pensada para ayudar a la comunidad sorda a entender la información del entorno en lugares públicos como aeropuertos o colegios, así como para ofrecer servicios de representación en cine, televisión y páginas web.

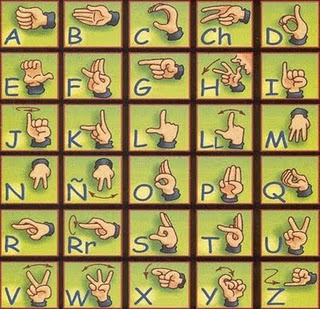

Dactilología

La dactilología es la representación manual de cada una de las letras que componen el alfabeto. A través de ella la personal sorda puede

transmitir cualquier palabra que desee comunicar, por complicada que ésta sea. El deletreo manual es usado en combinación con el

lenguaje de signos para sustantivos, nombres propios y palabras poco usuales para las cuales no existe un ideograma.

En el ámbito de la dactilología podemos encontrar:

- Aplicaciones y recursos para el aprendizaje

- LSC. Proyecto JClic cuya finalidad es iniciarse en el aprendizaje de la lengua de signos catalana. Se organizan en dos grandes grupos: Dactilología y vocabulario. El apartado de vocabulario incluye: los días de la semana, los colores, los meses del año y las emociones.

-

- DITS. El programa, desarrollado por el profesor Jose Luis Rodríguez Illera de la Universidad de Barcelona, posibilita el autoaprendizaje y ejercitación del alfabético dactilológico estructurando sus ejercicios en dos niveles: básico y avanzado.

-

- Manos que hablan. En esta página de podemos acceder a un diccionario y a un traductor dactilológico en linea, y a los alfabetos las lenguas de signos de diferentes paises.

- Recursos y servicios para la comunicación:

- El guante que habla. Desarrollado por la Universidad Rey Juan Carlos es un sistema de reconocimiento del lenguaje dactilológico que es capaz de traducir los gestos de la mano en palabra hablada y escrita en la pantalla de un ordenador. Se trata de un software que permitirá a los alumnos sordomudos, entre otras cosas, preguntar en clase o asistir a tutorías sin necesidad de un intérprete.

Sistemas Aumentativos de la Comunicación (SAC)

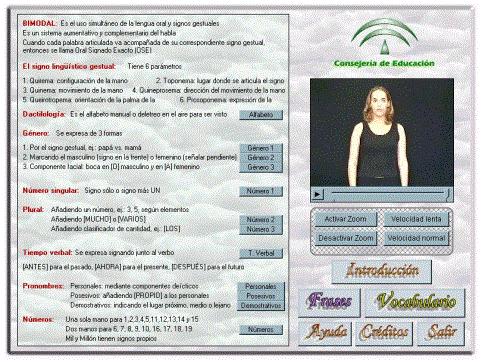

Comunicación Bimodal

El término bimodal fue introducido por Schlesinger (1978) para designar la asociación de dos modalidades: signada y hablada. La comunicación es bimodal cuando simultáneamente se emplea el habla junto a signos; es decir, la modalidad oral-auditiva junto a la modalidad visual-gestual. El mensaje se expresa en dos modalidades, pero la lengua base, la que marca el orden de la frase y la que determina la sintaxis de las producciones, es la lengua oral. Signos y habla se emplean simultáneamente para facilitar intercambios comunicativos y posibilitar un mejor aprendizaje del lenguaje oral.

El objetivo fundamental del sistema de comunicación bimodal es que las personas sordas desde la primera infancia desarrollen una competencia lingüística que les facilite el acceso al lenguaje oral.

Torres Monreal y Sánchez Rodríguez presentan algunas opiniones de profesionales y personas sordas sobre bimodal. En general, los profesionales lo valoran positivamente, indicando entre otras cuestiones:

- Su facilidad de aprendizaje y uso, además de su versatilidad para poderse aplicar a diferentes patologías o trastornos.

- Mejora las relaciones entre sordos y oyentes.

- Facilita la comunicación en los casos en que la expresión oral es inteligible.

- Mejora la estructura del habla en sujetos deficientes.

Por su parte, los sujetos sordos no valoran tan positivamente el sistema bimodal, pues señalan que:

- Su estructura es muy distinta a la Lengua de Signos, lo que crea cierta dificultad a las personas sordas que no tienen un suficiente desarrollo del lenguaje oralista.

- El bimodal entorpece el desarrollo propio del Lenguaje de Signos.

Existen muy pocos programas que se orienten al uso y aprendizaje de la comunicación bimodal. Podemos destacar:

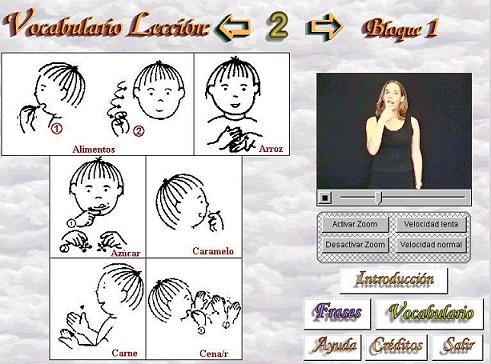

- Introducción a la Comunicación Bimodal Aplicación realizada por Jose Luis Amat con las herramienta de autor CLIC y NEOBOOK, destinada niños pequeños para la introducción y familiarización con el sistema de comunicación bimodal. La aplicación consta trabaja tres campos semánticos: Animales, Comida y Colores y, para ello, utiliza una serie de estímulos con diferentes entradas sensoriales: imagen, signo correspondiente, palabra escrita y palabra oída.

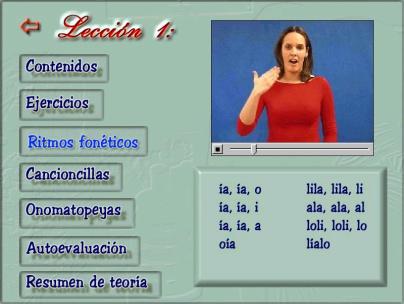

- Bimodal 2000. Es un curso multimedia para el aprendizaje básico de la comunicación Bimodal, como sistema aumentativo del habla, asistido por ordenador. Se trata de un programa multimedia elaborado para el aprendizaje autónomo de los signos manuales por J. Sánchez Rodríguez y S. Torres Monreal. Presenta una introducción y se divide su contenido en dos bloques frases y vocabulario. Cada uno tiene 18 lecciones, en cada lección nos encontramos con 10 frases y de 26 a 28 palabras.

La Palabra Complementada (LPC)

La Palabra Complementada o Cued Speech (LPC) fue creada en 1967 por Cornet en el marco de la educación de los niños y jóvenes sordos con el objetivo de facilitar la comprensión de los mensajes hablados. En la versión española, este sistema se dió a conocer en 1998 por Torres.

LPC no es un sistema signado ni gestual sino que es un método eminentemente oral en el sentido de que su objetivo es complementar la lectura labial, para ello, combina la lectura labiofacial con ocho configuraciones de la mano que se ejecutan en tres posiciones distintas respecto al rostro. Las configuraciones manuales permiten identificar las consonantes a través de tres parámetros: posición, forma y movimiento de la mano. Mientras que las vocales se corresponden con los diferentes lugares en los que son articuladas las configuraciones. Es necesario tener presente que LPC es un sistema fonético que representa lo que se oye y habla, y no lo que se escribe.

La información obtenida únicamente a través de las posiciones de la mano no es suficiente para la emisión ni recepción del mensaje. Se precisa la simultaneidad boca-mano. Los complementos manuales, también llamados kinemas, están desprovistos de contenido lingüístico, es decir, no tienen ningún significado al margen de la lectura labial. Es un complemento al habla y por tanto adquiere significado en combinación con ella, pues facilita la lectura labial al visualizar los fonemas no visibles y suprimir las ambiguedades.

La Palabra Complementada es un sistema que hace posible el desarrollo lingüístico oral en todos sus aspectos: fonológico, semántico, morfosintáctico y pragmático. En el estado actual de la investigación científica sobre el desarrollo lingüístico oral del sordo profundo prelocutivo, La Palabra Complementada ha de ser preferida, antes de los tres años de edad, a otros sistemas por su capacidad de instaurar la fonología como paso previo a otros desarrollos y manifestaciones del lenguaje. Con esta instauración previa de la fonología, el bebé y niño sordo está en igualdad de condiciones que su par oyente para abordar el desarrollo lingüístico en sus aspectos de contenido (significado de las palabras) y de forma (morfología y sintaxis).

Para facilitar el uso de LPC podemos utilizar el programa La Palabra Completada. Es una aplicación multimedia, desarrollada por José Sánchez Rodríguez y María José Ruiz Casas, con la que se pretende facilitar el aprendizaje de LPC. Su curso está compuesto de 8 lecciones e incorpora un tutorial en el que se presenta y describe LPC.

Utilizando este programa, resulta interesante el Método Oral Complementado (MOC) resultado del Convenio de cooperación entre la UMA y Delegación de Educación. Este método es un modelo estructurado de intervención logopédica basado en los avances de la Psicología Cognitiva, la Psicolingüística y la Neurolingüística. Sus objetivos son:

- Crear un puente entre la investigación básica y la práctica logopédica.

- Crear materiales para la intervención a partir de hallazgos científicos en investigación básica.

- Reunir un grupo de sujetos sordos prelocutivos cuyo único SAC haya sido La Palabra Complementada.

- Formación de profesionales y padres.

En su página web podemos acceder a información sobre su programa, metodología e instrumentos.

Lecturas recomendadas

- Arauz, Santiago et al. El implante coclear. Generalidades. Fundación Arauz en Sinfomed.org.ar. http://www.sinfomed.org.ar/Mains/temas/iccorto.htm

- Ferrer Manchón, Antonio (2002) Las tecnologías de ayuda en la respuesta educativa del niño con discapacidad auditiva. TecnoNEET 2002. II Congreso Nacional de Nuevas Tecnologías y Necesidades Educativas Especiales. Septiembre (2002). Murcia. http://www.tecnoneet.org/docs/2002/32002.pdf

- Fesord C.V. CD-ROM interactivo para el aprendizaje de Lengua de Signos '¡A signar!'. http://www.tecnoneet.org/docs/2000/II-142000.pdf

- González Rus, Gaspar(2006) Logopedia escolar digitalizada. Informe ISFTIC nº 18. Ministerio de Educación, Política Social y Deporte. http://ares.cnice.mec.es/informes/18/versionpdf.pdf

- González, Gaspar y López, Mª Mercedes (2002) Desarrollo de la discriminación del sonido en deficientes auditivos implantados. TECNONEET 2002. II Congreso Nacional de Nuevas Tecnologías y Necesidades Educativas Especiales. Septiembre (2002). Murcia. http://www.tecnoneet.org/docs/2002/4-32002.pdf

- José A. Rivas, MD; Adriana Rivas, MD; Flga. Marta Valbuena, Flga., Mireya Díaz, Flga. Elizabeth Bernal, Flga. Emilce Cabuya ('Clínica José A Rivas').La rehabilitación en implante coclear: una aproximación natural. http://www.encolombia.com/otorrino28200-rehabilitacion.htm

- National Academy of Sciences (2003) Sonido desde el silencio: el desarrollo de los implantes cocleares. http://www7.nationalacademies.org/spanishbeyonddiscovery/bio_007551.html

- Miguel Puyuelo y Mª Pilar San José (1999) Deficiencia auditiva. Aspectos neuropsicológicos y comunicativos. Intervención por medio de software educativo y técnicas de biofeddback. Comunicación presentada en el Primer Congreso Internacional de Neuropsicología en Internet: "Uniting horizons in Neuropsychology. http://www.uninet.edu/union99/congress/libs/lang/l02.html

- Monfort, M., Juárez, A., Martínez Sanjose, J., Barker N., Bermejo S., Gascón R., Mazagatos L., Onrrubia E. y Sánchez O. (2006) Sordera u nuevas tecnologías [en linea]. Monográfico del Observatorio Tecnológicos, Ministerio de Educación, Cultura y Deporte. Disponible en http://recursostic.educacion.es/observatorio/web/es/cajon-de-sastre/38-cajon-de-sastre/391-monografico-sordera-y-nuevas-tecnologias

- Moreno-Torres, I., Torres, S. y Santana, R. (2008) La investigación lingüística en audiología: Estudio de caso de un niño sordo con implante coclear y Trastorno de Atención. Comunicación presentada al VIII Congreso de Lingüística General 2008. Disponible en http://elvira.lllf.uam.es/clg8/actas/pdf/paperCLG82.pdf

- Rodriguez Illera, J.L. (1995) Dits: un programa informático para el aprendizaje del código dactilológico, Revista Comunicación Lenguaje y Educación, nº26. http://dialnet.unirioja.es/servlet/articulo?codigo=2941579

- Skliar, C. (2003) La educación de los sordos [en línea]. Artículo publicado en Espacio Logopédico disponible en http://www.espaciologopedico.com/articulos/articulos2.php?Id_articulo=305

- Torres Monreal, S. y Sánchez Rodríguez, J. (2001). Bimodal 2000. Comunicación y Pedagogía, nº 170.

Descargas

| Tema | Presentación | Documento PDF |

|---|

| 7. RECURSOS TECNOLÓGICOS PARA LA INTERVENCIÓN EN TRASTORNOS DE LA AUDICIÓN |  |  |

SOFTWARE

RECURSOS

| Página web | Recursos |

|---|

| En la escuela caben tod@s | Imágenes con el alfabeto dactilológico que pueden utilizarse para niños pequeños |

| TAGEDa. Tecnologías de Atención a la Diversidad en la Educación Gallega | En su galería multimedia ofrece pictogramas, sonidos y videos para comunicación bimodal, spc,... |

/

|